自主武器问答

红十字国际委员会高级科学与政策顾问尼尔·戴维森解释道,自主武器并非科幻小说中在遥远的反乌托邦未来才会出现的产物,而是当下就已引发人道关切,并且在国际政治层面需要立即予以应对的威胁。

何为自主武器?

在红十字国际委员会看来,自主武器是任何在没有人类干预的情况下选择目标并对其使用武力的武器。

自主武器由人类启动,但人类却无法确切知晓武器将予攻击的具体人员和物体,也无法准确得知攻击将在何地(或)何时发生。

其原因在于,自主武器会通过软件将传感器从环境中检测到的信息与"目标描述"进行比对,并在二者相匹配时触发攻击。

例如,传感器可能会检测到军用车辆的轮廓或人员的移动。触发攻击的正是车辆或受害者,而非使用者。

我们担忧的是,在这一过程中,缺少人类对使用武力的判断,从而导致难以控制此类武器的影响。

使用者在启动自主武器时,如何能够知晓触发攻击的车辆轮廓确实是军用车辆,而非民用车辆?

即使攻击对象确实是军用车辆,如若攻击之时周边区域出现平民则又该如何?

此类武器将于何时诞生?

地雷可以视作初级的自主武器。在许多冲突中,地雷由于其影响难以控制而对平民造成的严重伤害均得到了充分的记录。由此,国际社会于1997年一致同意禁止杀伤人员地雷。

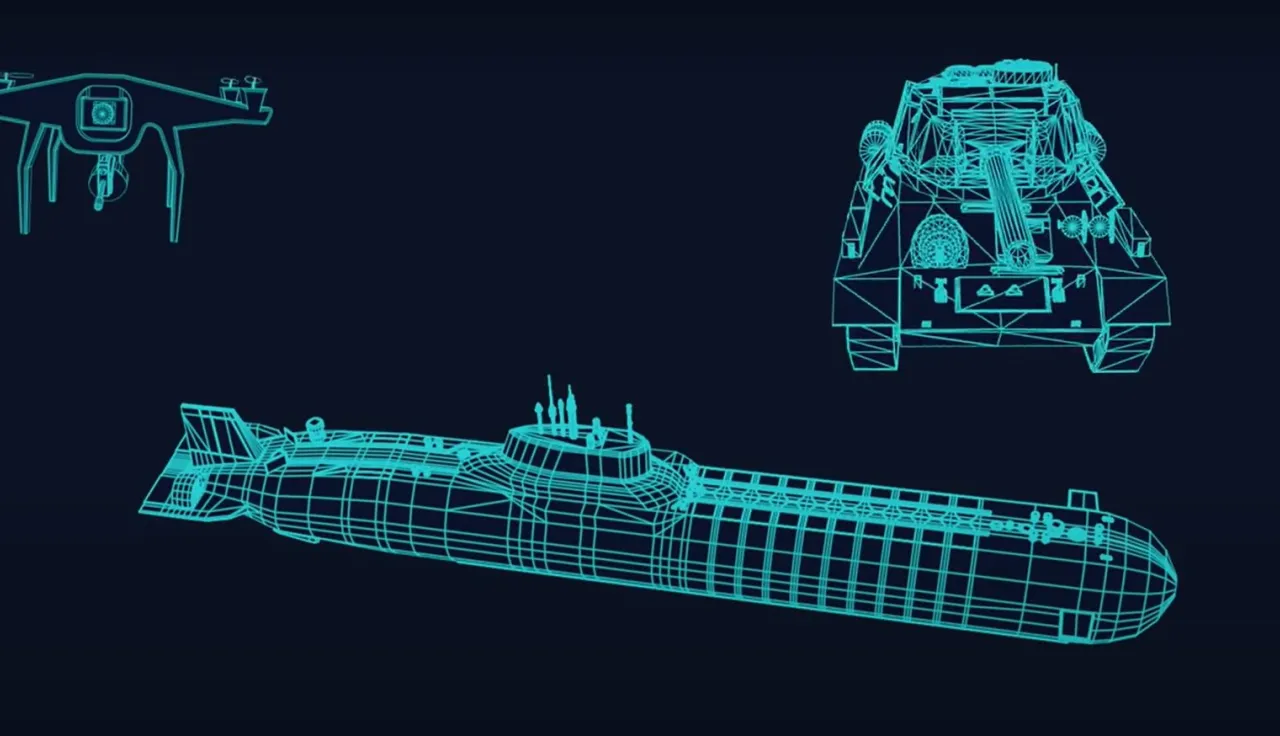

其他类型的自主武器也已研制,但往往仅在高度受限的情况下使用,如防空系统,用于攻打来袭导弹和一些巡飞弹药;或“神风敢死队”无人机,用于摧毁军用雷达、坦克或装甲车。

迄今为止,上述自主武器一般用于在几乎没有平民和民用物体的地区攻击明确的军事目标,包括武器、弹药、军用雷达和敌方坦克等。

另外,人类也往往对其进行严格监控,能够在局势有变或意外发生时将其关闭。

但武器技术和实践正在经历快速的变化。军方和武器研制人员有意将自主使用武力的特性纳入更为广泛的武器、平台和弹药中,包括目前通过操作员遥控的武装无人机。令人担忧的是,目前还出现了有意使用自主武器直接攻击人类的情况。

红十字国际委员会为何对自主武器感到担忧?

简而言之,自主武器由于其影响难以预测且难以限制,会造成人道风险、法律挑战和道德关切。

如上所述,自主武器增加了平民所面临的危险,而不再参与战斗的士兵,亦即已经投降或负伤的士兵,也同样面临更大的风险。

自主武器还可能会加速人类控制之外的武力使用。虽然在某些情况下,速度可能对军方而言是一项优势,但一旦失控,这就有可能使冲突以无法预测的方式升级,并使人道需求更为深重。

法律挑战

根据国际人道法,负责开展特定攻击的战斗员应评估战场具体情况,做出合法的判断。

而自主武器运作时,使用者却无法选择具体攻击目标,也无法决定确切的攻击时间和地点,就会导致难以做出上述判断。自主武器使用者基于何种条件,才能合理确定在当时情况下,武器仅会被真正合法的目标触发攻击,且不会对平民造成不成比例的伤害?

自主武器还会在法律责任层面引发挑战。在发生违反国际人道法的行为时,追究行为人的责任对于为受害者伸张正义、遏制日后的违反行为而言至关重要。通常,调查对象是使用武器开火的人员和下令攻击的指挥官。

但在使用自主武器的情况下,举例而言,如果一辆民用公交车受到攻击,有谁能够解释其中的原因呢?

在现行法律制度下,能否对被控犯有战争罪之人追究责任,尚存在诸多问题。

道德关切

最为根本的是,将生死抉择让予传感器和软件,引起了各方广泛而深切的担忧。

即使是在杀戮指令已有所常态化的冲突之中,人类也依然能够在道德机制的指引下进行决策,采取行动。

而自主武器却会在杀伤人员、摧毁物体的决策中减少,甚或有可能完全消除人类的能动性。这种非人化过程损害了我们的价值观,破坏了共同的人道。

所有危及人类的自主武器均会引发上述道德关切,但旨在或用于直接攻击人类的自主武器尤为令人担忧。

人工智能与机器学习在自主武器中发挥何种作用?

人们对于依赖人工智能,尤其是机器学习,来控制自主武器的兴趣日渐浓厚。

机器学习软件在数据方面“经验颇丰”,能够针对具体任务自行创建模型,并制定完成该任务的策略。此类软件在某种程度上能够自我编程。

通常,这种模型是一个“黑匣子”——换言之,人类极难对其进行预测、理解和解释,也难以测试机器学习系统以何种方式、在何种基础上实现特定评估或产出。

众所周知,在各类应用中,例如在警务工作中,机器学习系统也引发了编码歧视方面的关切,涉及种族、性别和性等因素。

而面对各类自主武器,使用者会极难预测其影响。如上所述,使用者甚或无法得知何人何物会触发攻击。机器学习控制的自主武器愈发强化了这一关切,因为此类武器在设计层面就存在不可预测性。

一些机器学习系统在使用期间还会继续“学习”,亦即所谓的“积极”“在线”学习或“自学”,这就表示其任务模型会随时间而发生变化。

在应用于自主武器的情况下,如果允许该系统在使用期间“学习”如何识别目标,使用者又如何能够合理确定攻击不会超出战争中法律允许的范围?

红十字国际委员会建议政府和其他相关方采取何种应对措施?

红十字国际委员会建议各国针对自主武器通过具有法律约束力的新规则。新规则将有助于防止平民承受重大伤害风险,应对道德关切,并有益于法律确定性和稳定性。

首先,对不可预测的自主武器应予禁止。此类武器指的是因设计或使用方式而使人无法充分理解、预测并解释所造成影响的自主武器,包括在使用过程中对目标进行“学习”的武器,也可能包括一般的机器学习控制的自主武器。

其次,旨在或用于直接对人类使用武力的自主武器应予禁止。

再次,需对所有自主武器的设计和使用制定严格的限制,以减轻上述风险,确保遵守法律,并应对道德关切。

作为国际人道法的捍卫者,红十字国际委员会不建议在制定新规则时较为宽松。

但与此同时,我们还在致力于促进法律逐步发展,从而确保现有规则不致削弱。我们希望确保为受冲突影响之人所提供的保护,并于必要时,在面对武器和作战方法不断演变的情况下加强这一保护。

正如对待杀伤人员地雷、激光治盲武器和集束弹药一样,我们需要制定具有法律约束力的新条约,保护平民和战斗员。必须在战争中保护人道。

制定的相关规则可作为《特定常规武器公约》 Convention on Certain Conventional Weapons (CCW)的新增议定书,也可另行形成其他具有法律约束力的文件。

就通过新规则而言,红十字国际委员会的乐观程度如何?

我们对各国将就自主武器的国际新规达成一致充满信心。大多数国家都认识到有必要在武力的使用中确保一定程度的人类控制和判断,这就意味着要对自主武器设定严格限制。

越来越多的国家已经做好准备,通过具体禁止性规定和相关限制。其他国家即使尚未制定新规,也已认识到需要设立此类限制。

此前曾对新规表示反对的国家中,有一部分开始表现出更为开放的态度,可能是受到了日益深化的多边讨论及近期冲突中相关进展的影响。目前就规制自主武器而言,已经有了可靠切实的解决方案。考虑到当前的军事技术进步和相关实践,我们迫切需要采用这些方案。

如今我们需要各国恪守原则的政治领导将上述解决方案纳入具有法律约束力的文件,保护后世子孙。